Jedes Unternehmen, das Produkte oder Dienstleistungen über eine Internetseite verkauft, sollte A/B-Testing betreiben. Denn A/B-Testing kann ein starker Treiber für die Conversion Rate verschiedener Seitenziele sein und viele Learnings über deine Zielgruppe und das Verhalten der UserInnen auf deiner Seite bieten. Richtig durchgeführt ist A/B-Testing zwar komplex und zeitintensiv, führt aber zu positiveren Ergebnissen, als planlos und überstürzt die Nadel im Heuhaufen zu suchen.

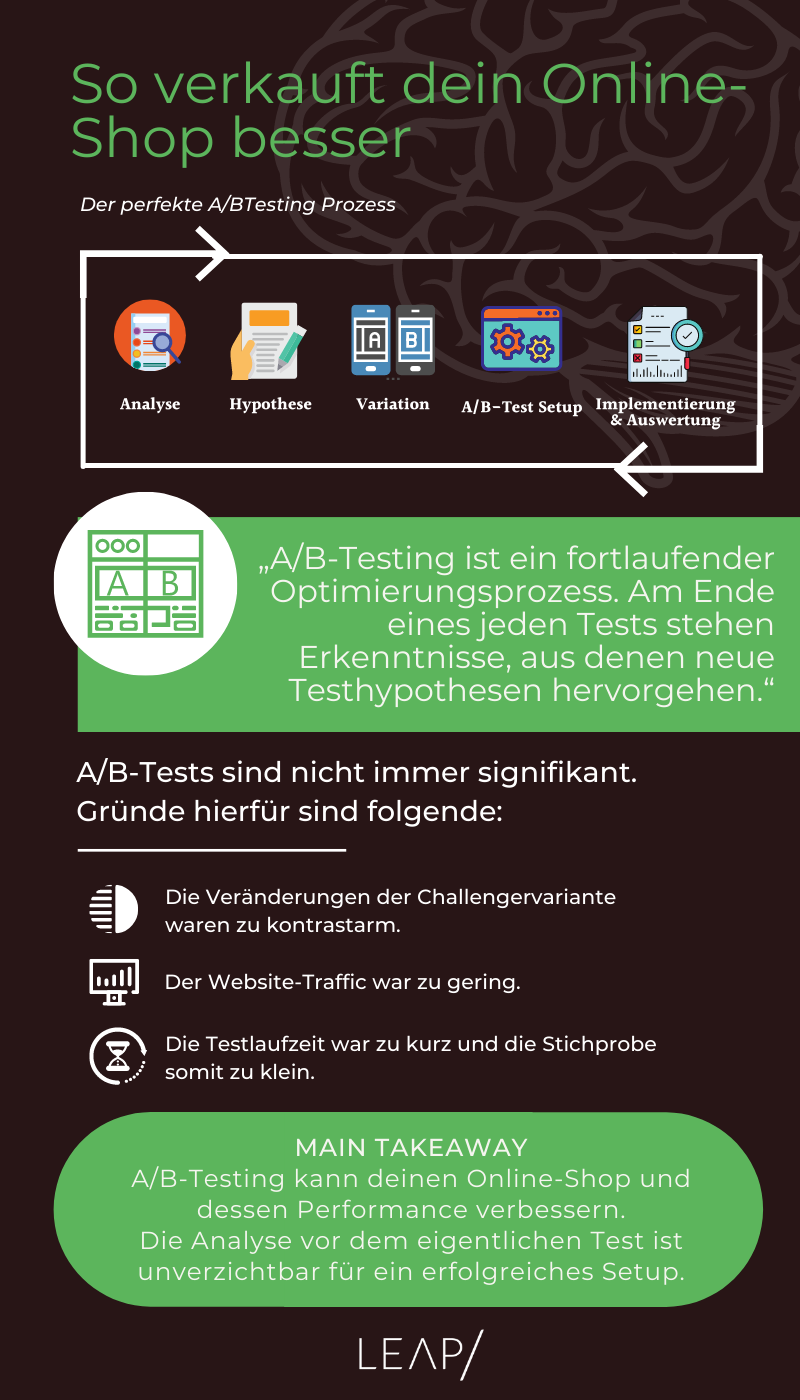

Damit deine Tests fehlerfrei laufen, erläutern wir dir gerne unser Vorgehen bei LEAP/ und beantworten im Anschluss daran einige typische Fragen. So nutzen wir einen bewährten A/B-Testing-Cycle, der sich nach sechs durchgeführten Schritten wiederholt:

1. Analyse

2. Hypothese

3. Variation

4. A/B-Test-Setup

5. Test-Durchführung

6. Auswertung & Implementierung

Du bist mehr der visuelle Typ?

Weiter unten findest du eine Infografik, die dir diesen Artikel übersichtlich zusammenfasst!

So kann man sich den Ablauf grob vorstellen

1. Analyse

Da es beim Testen eher um kleine Änderungen und die stetige Schritt-für-Schritt-Verbesserung der Conversion Rate geht, sollte deine Website vorher von Überflüssigem und groben Fehlern befreit werden.

Bevor du nun testest, musst du analysieren. Wenn du nicht weißt, auf welcher Seite die UserInnen am häufigsten abspringen und wo sich die User und Userinnen generell viel aufhalten, kann nicht getestet werden.

Es gibt zwei Phasen innerhalb der Analyse: die quantitative Analyse und die qualitative Analyse.

Quantitative Analyse: Bei der quantitativen Analyse werden insbesondere die Zahlen deines Analytics-Tools unter die Lupe genommen. Hierbei geht es darum, jene Seiten ausfindig zu machen, die zum Beispiel viel Traffic, aber eine hohe Bounce Rate oder eine geringe Conversion Rate aufweisen.

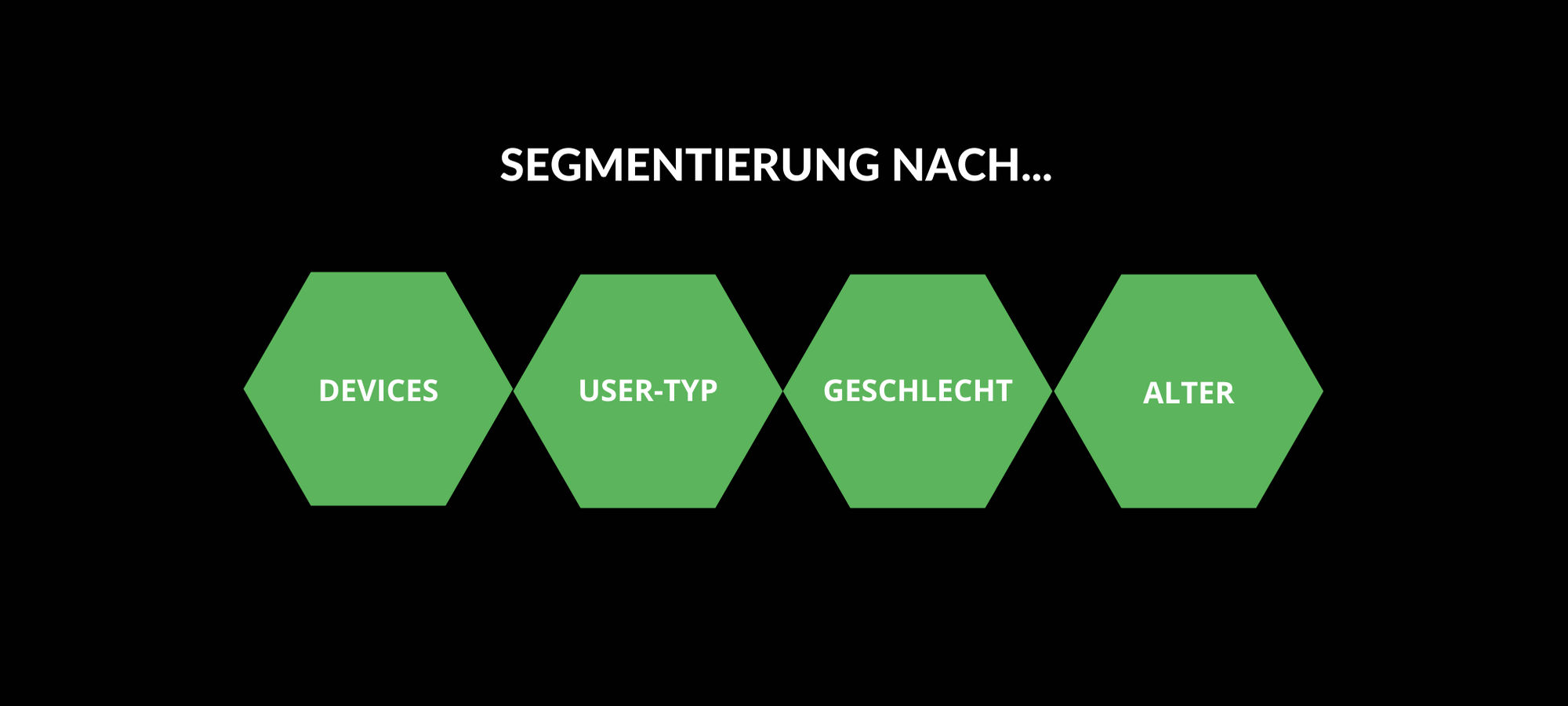

Aufschlussreich ist außerdem das Einsetzen von Segmenten nach Devices, Geschlecht, Alter, neue UserInnen, WiederkehrerInnen etc. Neben Analytics empfehlen wir die Verwendung von Trackingtools wie Mouseflow, damit du auszuwerten kannst, wie sich die Nutzer und Nutzerinnen auf deiner Seite verhalten. Wo wird beispielsweise besonders viel geklickt, obwohl der Klick nicht unbedingt gewollt oder von Vorteil ist?

Segmentierungen sind in der Regel sehr hilfreich

Qualitative Analyse: In der qualitativen Analyse werden auf der Seite selbst per Draufsicht mögliche Probleme unter Verwendung psychologischer Heuristiken, Best Practices und Quick Wins identifiziert, um daraus Hypothesen zu formulieren.

Interessant kann auch die Analyse der Wettbewerber sein, wenn etwa bestimmte Elemente auf der Seite anders gehandhabt werden. Weitere, aber aufwendige Methoden für die Hypothesengenerierung sind außerdem Usability Labs und User-Befragungen.

Empfehlung: Testing Roadmap erstellen

Nachdem klar ist, an welchen Stellen getestet wird und wie viele Tests es ungefähr sein werden, empfehlen wir eine Testing Roadmap zu erstellen. Bei LEAP/ nutzen wir ein System aus Backlog-Tests, die bei Bedarf in die Roadmap gezogen werden. Wir committen uns auf maximal fünf Tests hintereinander.

A/B-Testing ist kein statischer, sondern ein dynamischer und iterativer Prozess und fordert Flexibilität, um zum Beispiel Follow-up-Tests durchzuführen oder auf unternehmensbedingte Gegebenheiten reagieren zu können. Um die Entscheidung zu vereinfachen, welche Tests zuerst durchgeführt werden, priorisieren wir die Testideen nach folgenden Eigenschaften:

2. Hypothese

Die gefundenen Probleme – sowohl quantitativ als auch qualitativ – werden kombiniert und in Hypothesen formuliert. Die Formulierung sollte mit Zuhilfenahme einer Heuristik stattfinden, die die Hypothese unterstützend belegt. Das sieht dann wie folgt aus:

Wir empfehlen außerdem, das Design- und Programmierungsteam miteinzubeziehen, weil hier erstens weitere gute Ideen schlummern und zweitens auch schon in einem frühen Stadium auf mögliche Schwierigkeiten im Design oder der Programmierung hingewiesen werden kann. Das Programmierteam muss zudem entscheiden, wie die Tests technisch ablaufen sollen.

DTeamübergreifende Arbeit ist auch bei A/B Tests unverzichtbar

3. Variation

Je nachdem, wie viel Traffic auf der Testingseite vorhanden ist und ob das Testing-Setup es zulässt, empfehlen wir, mit mehreren Varianten zu testen, da die Wahrscheinlichkeit erhöht wird, zu einem positiven Ergebnis zu gelangen.

Wenn du beispielsweise überprüfen möchtest, ob ein Teaserbild mit oder ohne Testimonial besser performt, dann böte sich eine zweite Challengervariante mit zum Beispiel einer dritten Teaseridee an (multivariates Testing).

Natürlich kommt es darauf an, ob genügend Traffic vorhanden ist und ob mehrere Ideen überhaupt sinnvoll sind. Online gibt es verschiedene A/B-Testing-Laufzeit-Rechner, mit denen du ausrechnen kannst, wie lang der Test in verschiedenen Set-ups laufen würde.

Folgende Kennzahlen werden dazu benötigt:

1. Die aktuelle Conversion Rate des Primärziels wie etwa den Klick auf das Teaserbild

2. Die tägliche Useranzahl auf der entsprechenden Seite

3. Die erwartete Verbesserungsrate deiner Challengervariante (zum Beispiel die Steigerung der Klicks auf das Teaserbild um 10 Prozent). Je kleiner die erwartete Verbesserungsrate ist, desto länger wird die Laufzeit des Tests.

4. Das Konfidenzniveau: Die vorliegende Veränderung ist im besten Fall signifikant und damit auf die Grundgesamtheit, also alle User und Userinnen, übertragbar. Wir empfehlen hier mit einem Konfidenzniveau von 95 Prozent zu arbeiten, um so nur 5 Prozent Risiko eines Fehlers erster und zweiter Art zuzulassen. Ein Fehler erster Art liegt vor, wenn die Challengervariante als der Gewinner identifiziert wird, obwohl die Originalvariante der Gewinner ist. Ein Fehler zweiter Art liegt vor, wenn die Originalvariante beibehalten wird, obwohl die Challengervariante besser performt. Weitere häufige Fehler findest du hier.

Sobald die Varianten konzipiert sind und berechnet wurde, ob der Test möglich ist oder gegebenenfalls verändert werden muss, werden die Varianten vom Design erstellt und durch Qualitätskontrollen und Feedbackschleifen feingeschliffen.

4. A/B-Test-Setup

Beim Test-Setup wird der Test ins Development gegeben und programmiert. Außerdem gilt es, die genauen Targeting- und Conversionziele im Testingtool festzulegen. Neben dem Primärziel werden Sekundärziele definiert, die ebenfalls getestet werden sollen. Wir empfehlen jeden Weg und wichtigen Klick, den der Nutzer oder die Nutzerin während des Tests gehen oder tätigen könnte, mit aufzunehmen. Nimm dir hier ausreichend Zeit und überlege insbesondere, welche Interaktion wichtig ist.

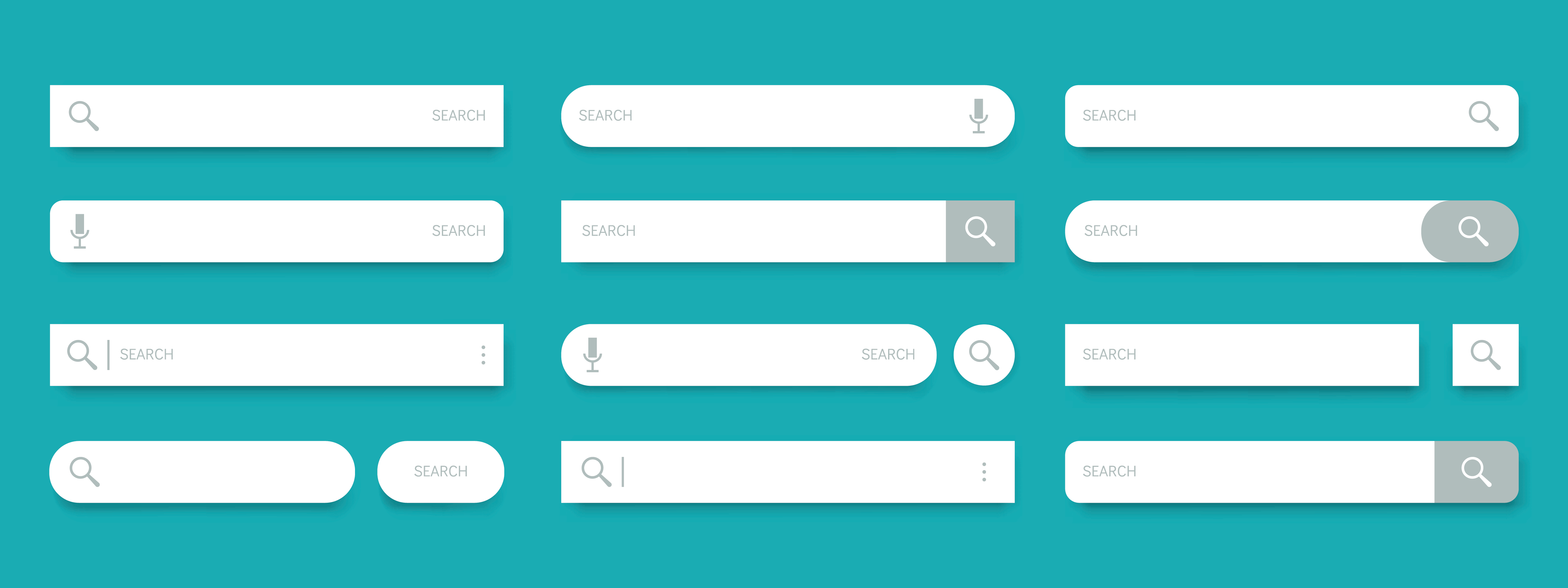

Wenn du zum Beispiel die Suche im Test ausklappen möchtest, dann muss hier jede Interaktion ins Targeting: Nutzung der Suche gesamt, Klick auf Lupe, Klick auf Eingabe, Klick auf Liste mit Suchergebnissen (falls vorhanden). In diesem Beispiel ist nicht nur interessant, wie die UserInnen generell auf die ausgeklappte Suche reagieren und ob es sich positiv auf den Sale oder Add to Cart auswirkt, sondern auch wie die User und Userinnen agieren, nachdem sie die Suche genutzt haben. Für diese Betrachtung kann im Testingtool ein Action Tracking eingestellt werden. Das Action Tracking ist allerdings nur möglich, wenn die Nutzung der Suche vorher als Ziel definiert wurde. Daher überlege dir vorher genau, was wichtig ist und welches Action Tracking du gegebenenfalls für die Auswertung benötigst.

Die Suche kann sehr variabel ausfallen

Hier ist eine Liste mit Zielen, die wir immer ins Targeting aufnehmen, wenn der Test vor dem Check-out stattfindet:

Wenn der Test programmiert und alle Ziele ins Targeting aufgenommen wurden, sollte vor der Liveschaltung eine ausführliche Prüfung der Funktionalität auf den gängigen Browsern und Geräten erfolgen. So lassen sich mögliche Fehler vorher identifizieren und beheben.

5. Test-Durchführung

Endlich ist es soweit – der Test ist live! Doch damit ist die Arbeit nicht getan. Vielmehr solltest du den Test jeden Tag im Testingtool monitoren, um Verläufe zu beobachten und Fehler während des Tests direkt beheben zu können. Außerdem können Varianten umgeleitet oder der Test abgestellt werden, wenn eine negative Performance auftritt.

6. Auswertung & Implementierung

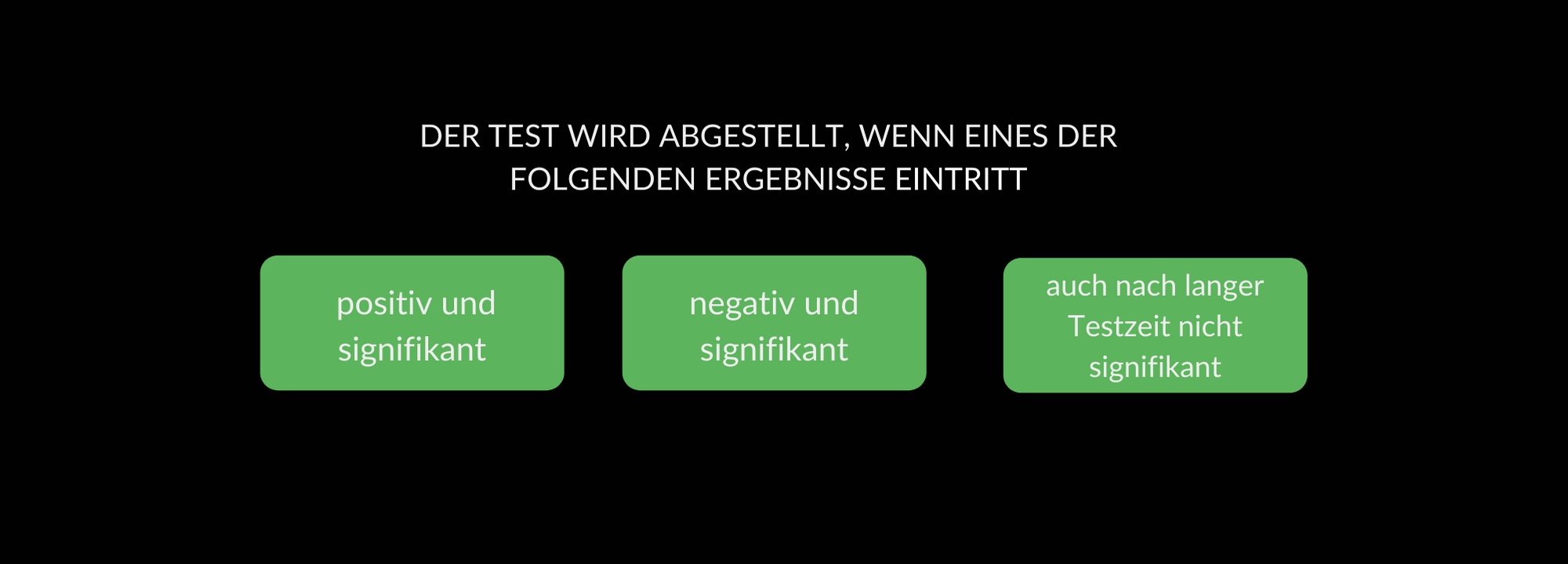

Wann der Test abgestellt werden kann, entscheidet einer dieser drei Gründe:

Es gibt nur 3 mögliche Outcomes bei einem A/B Test

Im Fall 1 und 2 können die Ergebnisse ausgewertet und gegebenenfalls Follow-up-Tests aus den Learnings generiert werden. Hierbei ist es wichtig, nicht nur die Gesamtergebnisse zu evaluieren, sondern zusätzlich zu segmentieren, da sie aufschlussreiche Erkenntnisse über die Zielgruppe, die Nutzung und das Verhalten enthalten können. Eine Segmentierung kann beispielsweise Klickziele, bestimmte Seitenaufrufe, Devices, Browser etc. beinhalten.

Fall 3 tritt tatsächlich am häufigsten auf, und irgendwann musst du die Entscheidung treffen, den Test trotz niedrigen Signifikanzniveaus abzuschalten. Auch wenn nicht alle Ziele die gewünschte Signifikanz aufweisen gibt es meist trotzdem Ergebnisse, die ausgewertet werden können – etwa durch eine Segmentierung.

Wie geht man mit unterschiedlichen Ergebnissen nach einer Segmentierung vor?

Du hast segmentiert und stehst nun vor dem Dilemma, dass zum Beispiel eine Veränderung im Chrome-Browser positiv und im Safari-Browser negativ performt. Alles in allem sind solche Fälle normal und geben dir wichtige Learnings über die Zielgruppe und die Performance der einzelnen Segmente.

Die Segmentierung hat jedoch nur einen begrenzten Einfluss auf die Entscheidung, ob Challengervarianten umgesetzt werden oder das Original beibehalten wird. Beeinflusst die Veränderung das Primärziel, den Sale oder Umsatz negativ, muss pro „großem Ganzen“ agiert werden, auch wenn signifikante Uplifts an anderer Stelle vorhanden sind.

Dennoch lassen sich die positiven und signifikanten Ergebnisse nutzen, indem du anhand der Learnings personalisierst. Das Thema der Personalisierung wird hier behandelt: „Personalisiere deine Website – Tipps und Tricks aus der Psychologie“.

Ist es ungewöhnlich, dass nicht jeder Test erfolgreich ist?

Nein, ist es nicht. Viele Seiten im Internet sind fortgeschritten optimiert und die meisten „Low Hanging Fruits“ bereits gepflückt, was zur Folge hat, dass insgesamt weniger positive Tests gemacht werden. Eine anfängliche Idee kann zum Beispiel durch einen Misserfolg zu einem positiven Ergebnis führen, weil aus den Learnings Follow-up-Tests konzipiert werden.

Entsprechend heißt es im Handbuch „A/B-Testing 1×1 – Wie Sie Ihr Unternehmen mit A/B-Testing ganz nach vorne bringen“ von AB Tasty: „A/B-Testing ist ein fortlaufender Optimierungsprozess. Am Ende eines jeden Tests stehen Erkenntnisse, aus denen neue Testhypothesen hervorgehen. Diese helfen wiederum dabei, die Roadmap auszubauen. Zudem werden die Bemühungen nur langfristig Früchte tragen: Die ersten Tests werden mit Sicherheit nicht die erhofften Ergebnisse liefern, denn eine fundierte Analyse nimmt Zeit in Anspruch.“

Wie funktioniert die Statistik bei einem A/B-Test?

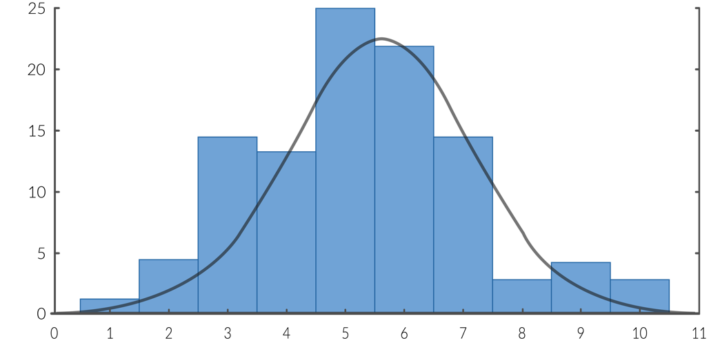

Es werden Werte einer Stichprobe gesammelt, woraus sich bei Vorhandensein ausreichend vieler Daten eine Gaußsche Glockenkurve oder auch Normalverteilung bilden lässt (s. Beispiel 1). Hier essen beispielsweise 25 Befragte fünf Tafeln Schokolade im Jahr.

So kann eine Gaußsche Glockenkurve bzw. Normalverteilung aussehen

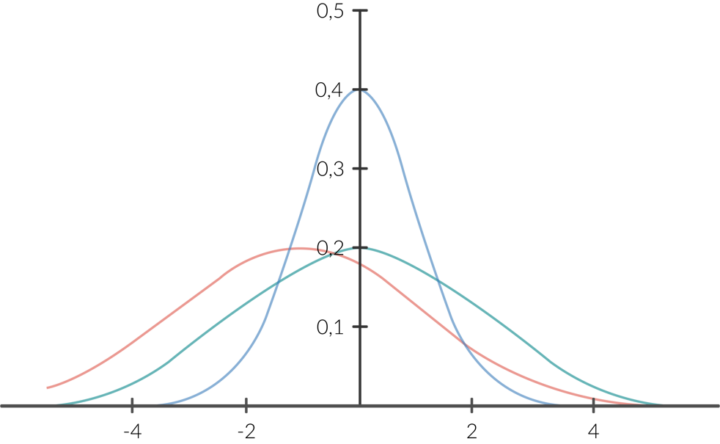

Wenn wir mehrere Varianten haben (z. B. Vollmilch, Zartbitter und Haselnuss), werden entsprechend viele Kurven gebildet.

Die Kurven im Vergleich

Die blaue Kurve hat die geringste Standardabweichung, d. h. die Daten streuen weniger stark um den Mittelwert.

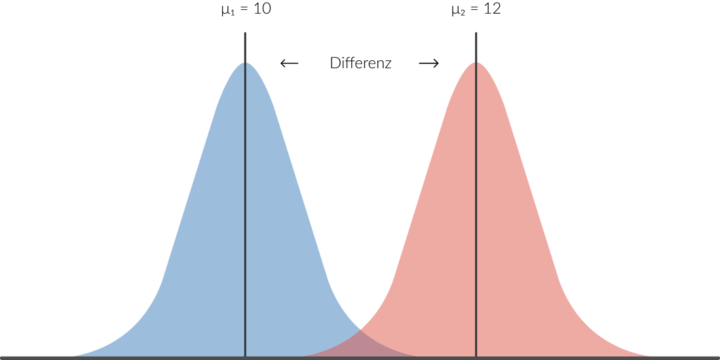

Bei einem t-Test werden die Mittelwerte miteinander verglichen, um einen Mittelwertunterschied herauszufinden (s. Beispiel 3). Dieser Unterschied muss hinsichtlich seiner Signifikanz überprüft werden. Die Signifikanz ist die Wahrscheinlichkeit, dass ein gefundener Unterschied nicht auf rein zufällige Schwankungen zurückzuführen ist und wird mit dem Chi-Quadrat-Test berechnet.

Die KuDie Differenz

Wie funktioniert die Statistik bei einem A/B-Test?

A/B-Tests können insbesondere aus drei Gründen nicht signifikant sein:

Warum macht man nicht einfach eine Vielzahl an Tests gleichzeitig?

Es wäre natürlich sehr praktisch, wenn wir vier Tests gleichzeitig auf der Seite laufen lassen. Dieses Vorgehen spart Zeit und führt zudem zu schnelleren Ergebnissen. Wir raten allerdings dringend davon ab, mehrere Tests gleichzeitig durchzuführen!

Hier sind die Gründe:

Mehrere Tests gleichzeitig laufen zu lassen, ist jedoch dann möglich bzw. sinnvoll, wenn beispielsweise eine Aufteilung nach Devices vorgenommen wird (Desktop und Mobile).

Fazit

Mit diesem A/B-Testing-Wissen bist du nun in der Lage, A/B-Tests auf deiner Seite durchzuführen. Genauso wie wir es hier bei LEAP/ machen. Wenn du unserer Anleitung folgst, wird sich deine Conversion Rate sowie die User Experience auf deiner Seite nach und nach verbessern. Nimm vor allem den ersten Schritt der Analyse sehr ernst! Denn die Tests sind immer nur so gut, wie die Analyse detailliert ist.

Viel Erfolg beim Testen!