Links sind das wichtigste Ranking-Signal – sowohl nach oben, als auch nach unten. Viele werden sicher vor allem dem zweiten Teil des Satzes zustimmen. Doch warum sind Links so eminent wichtig, um bei den Suchmaschinen weit oben zu landen? Dieser Frage gehe ich in meiner neuen Artikelreihe auf den Grund. Den Anfang macht die Frage: Warum geht auch im Jahr 2024 in vielen Fällen nichts ohne Backlinks?

Der Pinguin-Schock

In vielen Unternehmen und Agenturen sitzt der Schock über die ersten Pinguin-Updates auch nach mehreren Jahren noch tief. Denn diese haben das Ranking-Profil von zahllosen – teils großen und namhaften – Websites ordentlich durcheinandergewürfelt. Wenn ich heute mit den Chefetagen von solchen Unternehmen spreche, dann ist der Google Pinguin selbst dort ein Begriff. Viele CEOs hören zwar vielleicht nur einmal im Jahr von SEO (nämlich im Budgetmeeting), wissen aber trotzdem, dass hier eine Gefahr für ihr Unternehmen lauert.

Mit anderen Worten: Google hat ganze Arbeit geleistet. Die Marketing-Abteilung von Google hat das geschafft, woran die hochbezahlten Programmierer jahrelang gescheitert sind: Den Webmastern und SEOs Angst vor einer Abstrafung wegen unnatürlichen Links zu machen.

Google hat es bis heute nicht geschafft, die Algorithmen von ihrer Abhängigkeit von den Backlinks zu befreien. Doch wie kam diese Notwendigkeit, auf Links zu setzen, überhaupt zu Stande? Verzeihe mir im Folgenden bitte die stark vereinfachte Darstellung des Google-Algorithmus und des Pinguin-Updates. Selbstverständlich sind beide wesentlich komplexer, aber ich möchte dir hier die grundsätzlichen Arbeitsweisen verdeutlichen.

Die Säulen der Suchmaschinen

Schauen wir uns die Entwicklung der Suchmaschinen einmal chronologisch an. Um zu verstehen, was Backlinks heutzutage für das Google-Ranking bedeuten, lohnt sich ein Blick in die Vergangenheit.

Die zwei Säulen der frühen Suchmaschinen

Vor Google – Leser und Leserinnen in meinem Alter werden sich an diese tristen Zeiten erinnern – gab es auch schon Suchmaschinen. Die hießen damals Altavista, Alltheweb.com, Lycos oder Fireball und sahen aus heutiger Sicht so aus wie Opas synthetische Stoffhosen aus volkseigener Produktion aus den 70er Jahren.

Optisch nicht das Gelbe vom Ei: Lycos anno 1999 und Opas Hose

Doch auch diese Suchmaschinen waren in ihren Anfangstagen etwas wirklich neues und modernes. Noch bei ihren Vorläufern, den Webkatalogen, ordneten Menschen aus Fleisch und Blut die Websites „händisch“ in passende Kategorien ein, durch die der Nutzer bzw. die Nutzerin sich dann klicken konnte. Bei Lycos und Co. errechnete hingegen ein Algorithmus, welche Seiten im Hinblick auf eine Suchanfrage relevant sein könnten.

Diese frühen Suchmaschinen basierten im Grunde auf zwei Säulen: Content und Tech-SEO.

Die zwei Säulen der frühen Suchmaschinen

Ein relativer einfacher Algorithmus berechnete, welche Website für welches Suchwort oben stehen sollte. Und das tat er auf Basis der Inhalte und des technischen Aufbaus der Seite. Daher waren relativ einfache Methoden der spammigen Suchmaschinenoptimierung überaus erfolgreich. Vielleicht erinnerst du dich an Taktiken wie weiße Textwüsten auf weißem Hintergrund, in denen das Ziel-Keyword unzählige Male verwurschtelt wurde.

Zu dieser Zeit war die Arbeit des Suchmaschinenoptimierers oft sehr banal – und hatte in vielen Fällen einen negativen Einfluss auf die Suchergebnisse. Es war also Zeit für einen neuen Player. Und dieser trat 1999 mit einer revolutionären Idee auf den Plan.

Die drei Säulen der moderneren Suchmaschinen

Dabei handelte es sich natürlich um Google; die Suchmaschine, deren Name mittlerweile zum Synonym für das Suchen im Internet geworden ist. Und die Idee, die alles auf den Kopf stellte, war die Nutzung von Backlinks für das Ranking.

Die drei Säulen nach dem Start von Google

Seit jeher betrachtet Google einen Link, der auf eine Seite zeigt, als eine Empfehlung. Dadurch, dass die Algorithmen aus dem Hause Google diese Empfehlungen wörtlich nahmen und ins Ranking einfließen ließen, konnten sie die Qualität ihrer Suchergebnisse im Vergleich zur Konkurrenz dramatisch erhöhen. Backlinks waren daher einer der zentralen Schlüssel zu Googles durchschlagendem Erfolg.

Der Suchmaschinenriese folgte dabei schon immer einem Mantra: Man wollte dem Nutzer bzw. der Nutzerin die bestmöglichen Suchergebnisse liefern. Daher wurde auch die Betrachtung der Backlinks immer weiter angepasst und verfeinert. Genügte es am Anfang noch, möglichst viele dieser Empfehlungen einzusammeln – egal woher – so wurde mit den Jahren auch die Quelle der Links immer wichtiger. Grob gesagt wollte Google Links von Seiten sehen, denen die Suchmaschine vertraut. Masse statt Klasse also.

Der Pinguin änderte alles

Doch da es genug für ein eigenes Buch wäre, diese ganzen Iterationsschritte einzeln aufzudröseln, springen wir direkt wieder ins Jahr 2012. Im Jahr 13 n. G. (nach Google) gab es weltweit bereits eine sehr aktive SEO-Szene. Und diese musste durch den ersten Pinguin Verluste von unbekannten Ausmaßen hinnehmen.

Das erste Update rollte am 24.04.2012 aus und betraf etwa 3-5 % aller Websites (das hört sich erst einmal nicht nach viel an, aber überleg mal, wie viele Seiten es im Index gibt). Und nicht nur das: Mit der überraschenden Veröffentlichung sagte Google dem Webspam offiziell den Kampf an. Doch warum eigentlich?

Nun, auch Googles System zur Klassifizierung von Websites wurde von den SEOs schnell durchschaut. Während früher Content-Spam für gute Rankings sorgte, war nun der Linkspam an diese Stelle getreten. Die Umsatzsteigerungen, die sich nach der Jahrtausendwende nur durch den massiven Aufbau von Backlinks erreichen ließen, waren schon beinahe obszön.

Es herrschte eine Goldgräberstimmung sondergleichen. Ein 15-jähriger Techie konnte in seinem Kinderzimmer eine Affiliate-Website aufbauen, die vor allem durch den exzessiven Einsatz von Backlinks innerhalb kürzester Zeit monatlich 6-stellige Umsätze abwarf. Wenig überraschend bildete sich schnell eine ganze Branche, die sich nur um das Thema „Aufbau von Backlinks“ drehte.

Google sah also – vollkommen zurecht – eine große Gefahr für die Qualität der SERPs. Für viele Suchanfragen rankten Seiten ganz oben, die nicht einmal annährend „das beste Ergebnis für den oder die UserIn” darstellten. Google holte also mit dem Pinguin die grobe Keule heraus. Und die Sichtbarkeitsentwicklung vieler Websites sah auf einmal so aus:

Halbierung der Sichtbarkeit von kreuzfahrt.de im Google Index um den 25.04.2012

Das Wettrennen zwischen Google und den SEOs

Doch wie bei jeder Änderung an den Ranking-Algorithmen währte auch diesmal der Schock nur kurz. Schon bald begannen SEOs damit, die einzelnen Bestandteile der Pinguin-Algorithmus-Veränderungen zu analysieren. Dabei kam heraus, dass Google einige Filter in den Algorithmus eingebaut hatte. Diese sollten natürliche Backlinks von künstlichen unterscheiden.

Unter anderem wurde ein schon vorher bestehender Filter deutlich verschärft. Dieser zielte auf die Anchor Text Distribution ab: Wer viele Links von Websites bekam, die in ihrem Linktext ein Money Keyword hatten (das Keyword, für das die Ziel-URL ranken soll, am besten im Shorthead-Bereich – also mit vielen monatlichen Suchanfragen und einer hohen Transaktionswahrscheinlichkeit), bekam auf die Mütze.

Google konnte über seine unvergleichlichen Datenbestände sehr einfach auswerten, wie die Verteilung der Anchor Texte bei normalen Websites (ohne künstlichen Aufbau von Backlinks) aussah. Diese verlinkten normalerweise mit dem Brand (“ing diba”, “ingdiba”, “ing-diba.de” usw.) und eben nicht mit Money Keywords (“Girokonto kostenlos”).

Daher kann man die ersten Penguin-Updates grundsätzlich als eine Verschärfung der Filter verstehen. Bei jeder Verstärkung solcher Filter besteht jedoch die Gefahr, dass auch „Unschuldige”, die noch nie selbst einen Link aufgebaut haben, in Mitleidenschaft gezogen werden. Umso schärfer der Filter, desto höher die Wahrscheinlichkeit auf Kollateralschäden. Das führte natürlich dazu, dass Google diese mit Bedacht einsetzen musste.

Und egal, wie komplex ein Pinguin-Update auch war: jedes Mal konnten findige Suchmaschinenoptimierer relativ schnell herausfinden, welche Filter verschärft wurden. Entsprechend konnten sie reagieren und ihre Linkaufbau-Strategien anpassen.

Das Ergebnis: Es wurden weiter Links aufgebaut und das Katz-und-Maus-Spiel zwischen Google, die den Algorithmus änderten und SEOs, die daraufhin die Art des Linkaufbaus anpassten, wurde fortgesetzt.

Angst vor kompletter Deindexierung

Die von Google erhoffte abschreckende Wirkung des Pinguin war also nur zum Teil gegeben. Es musste also eine neue Strategie her. Und im August 2014 wurde es dann nochmal sehr interessant:

Mit solch deutlichen Worten gingen die Google-Mitarbeiter in die Offensive

Ähnliche Ankündigungen gab es von Google-MitarbeiterInnen zuvor unter anderem in den USA und in Frankreich. Google hat damit, nicht zuletzt aus Marketinggründen, einen öffentlichen „Schauprozess“ abgehalten. Die Domains der deutschen Backlink-Anbieter Rankseller und Teliad wurden von Google aus dem Index genommen. Dazu wurden Blogger und Bloggerinnen, die auf ihrer Website sehr offensiv für den Kauf von Backlinks warben, gleich mit deindexiert.

Die Message von Google war klar und deutlich: Du machst unnatürlichen Linkaufbau, wir wissen es und hauen dir auf die Nuss!

Das hatte natürlich drastische Auswirkungen auf die AnbieterInnen dieser Backlink-Marktplätze. Viele Kunden und Kundinnen kündigten binnen kurzer Zeit ihre Verträge. Die Nachricht sprach sich rum und sorgte – sowohl bei PublisherInne, als auch bei Unternehmen – vor allem für eins: Angst, das nächste Opfer zu sein; Angst, abgestraft zu werden.

Das Marketing schafft, woran die ProgrammiererInnen scheitern

Und so kommen wir zu meiner Aussage vom Anfang zurück: Die Programmierer und Programmiererinnen von Google – die nicht ohne Grund zu den besten ihrer Zunft zählen – bekommen die Backlinks nicht in den Griff.

Letztendlich demaskieren Googles Maßnahmen aus dem August 2014 also vor allem die große Schwäche des Google Algorithmus. Google ist auf Backlinks angewiesen und bis heute nicht in der Lage, das Problem des unnatürlichen Linkaufbaus algorithmisch zu lösen. Noch immer kann Google nicht zu 100 % zwischen unnatürlichem und natürlichem Linkzuwachs unterscheiden. Wenn der Linkbuilder oder die Linkbuildnerin keine Footprints hinterlässt, die von einer Maschine ausgelesen und ausgewertet werden können, dann sind Googles Möglichkeiten stark begrenzt.

Die „Propaganda-Maßnahmen” zeigten allerdings ihre beabsichtigte Wirkung. Aus Angst, ebenfalls manuelle Maßnahmen zu erhalten, stellten viele Unternehmen den Aufbau von Backlinks komplett ein. Die offiziellen Sprachrohre des Suchmaschinengiganten hatten also auf dem Feld der Linkspam-Bekämpfung deutlich mehr Erfolg als ihre Kollegen aus der Programmiersparte.

Die vier Säulen der aktuellen Suchmaschinen – Links braucht es immer noch

Fakt ist jedoch, dass Google nach wie vor auf Backlinks angewiesen ist, um gut von schlecht zu unterscheiden. Natürlich sieht der Algorithmus nach diversen Google-Updates heute anders aus als noch vor wenigen Jahren. Der Fokus verschiebt sich in Richtung Usersignale. Mit RankBrain und ähnlichen Anpassungen versucht Google, zu validieren, ob der Algorithmus das richtige Ergebnis nach oben gespült hat.

Die Nutzererfahrung als vierte Säule

Ab dem Zeitpunkt, wo Google Traffic über seine Suchergebnisse auf eine Ziel-URL schickt, versuchen sie, über zahlreiche Parameter zu validieren, ob der Nutzer oder die Nutzerin mit dem Ergebnis auch zufrieden ist. Allerdings hat Google diese Nutzersignale nicht, bevor sie Traffic auf die Seite schicken. Sie dienen also nur für nachträgliche Anpassungen der Algorithmen.

Die Statistiken für die meisten Keywords in der Google Search Console zeigen, dass der Nutzer oder die Nutzerin im Grunde genommen nur auf der ersten Google-Suchergebnisseite auf ein Ergebnis klickt. In vielen Fällen verteilt sich der Traffic sogar auf die ersten Suchergebnisse. Nur diese Seiten werden also für Google auswertbare Nutzersignale erhalten (diese müssen dann natürlich positiv sein, weshalb SEO immer Hand in Hand mit der Conversion-Optimierung gehen sollte!). Doch zu jedem wichtigen Keyword gibt es fraglos mehr als 10 relevante Antworten. Und an diesen muss man erst einmal vorbeikommen, um es dann in die Gruppe der Seiten zu schaffen, die Google sich genauer anschaut.

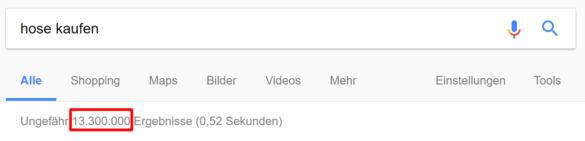

Viele Ergebnisse – wer rankt also oben?

Fazit: Man braucht Links, um die anderen 13.299.999 hinter sich zu lassen

Wie entscheidet Google nun, welche dieser 13 Millionen Seiten ganz vorne landen? Ganz vereinfacht ausgedrückt verhält es sich folgendermaßen:

Die technischen Faktoren sind die Basis. Sie stellen unter anderem sicher, dass die Website gecrawlt werden kann, dass die Inhalte erfasst werden können und dass die Ladezeit annehmbar ist. Über semantische Faktoren (Content) wird berechnet, wie groß die Relevanz eines Dokuments für ein bestimmtes Keyword ist.

Und dann kommen die Backlinks ins Spiel: Die Links – oder die Anzahl der Empfehlungen, die ein Dokument erhält – sorgen dafür, dass es überhaupt in die Richtung der TOP 10 kommen kann. Sie sind also das Salz in der Suppe auf dem Weg nach oben. Und wer keine hat, wird in den meisten kompetitiven Themenbereichen einfach nicht gut genug ranken. Dann gibt es auch keine hilfreichen Nutzersignale.

Jeder Website-Betreiber und jede Website-Betreiberin sollte sich daher Gedanken machen, wie er oder sie dieser Säule im Google-Algorithmus gerecht werden kann. Denn eines ist klar: Die Dominanz der Links wird nicht heute oder morgen beendet werden (können).