Eine Logfile-Analyse hilft dir zu verstehen, was Google sieht. Da der Google-Crawler jede Änderung der Website erst erkennen muss, ist es wichtig zu wissen, ob der Bot die geänderten oder neuen Unterseiten überhaupt schon gecrawlt hat. Das Crawling dient der Entdeckung einer Seite und ist der Anfang der Indexierung.

Durch die Logfile-Analyse siehst du, ob Google wichtige Seiten anschaut oder aber viele unwichtige Unterseiten (z. B. Parameterseiten oder doppelte Seiten) crawlt. Dein Ziel ist es, dass Google möglichst oft die Seiten anschaut, die du im Google-Index haben möchtest.

Das Crawlverhalten an sich ist kein Rankingfaktor. Das häufige Crawlen indexierter Unterseiten garantiert, dass Google

1. Änderungen indexiert und

2. die Relevanz wichtiger Unterseiten versteht.

Eine kurze Erklärung zum Vorgehen von Google liefert der Beitrag „Verarbeitung von Informationen in der Google-Suche“.

Du bist mehr der visuelle Typ?

Weiter unten findest du eine Infografik, die dir diesen Artikel übersichtlich zusammenfasst!

Wer braucht eine Logfile-Analyse?

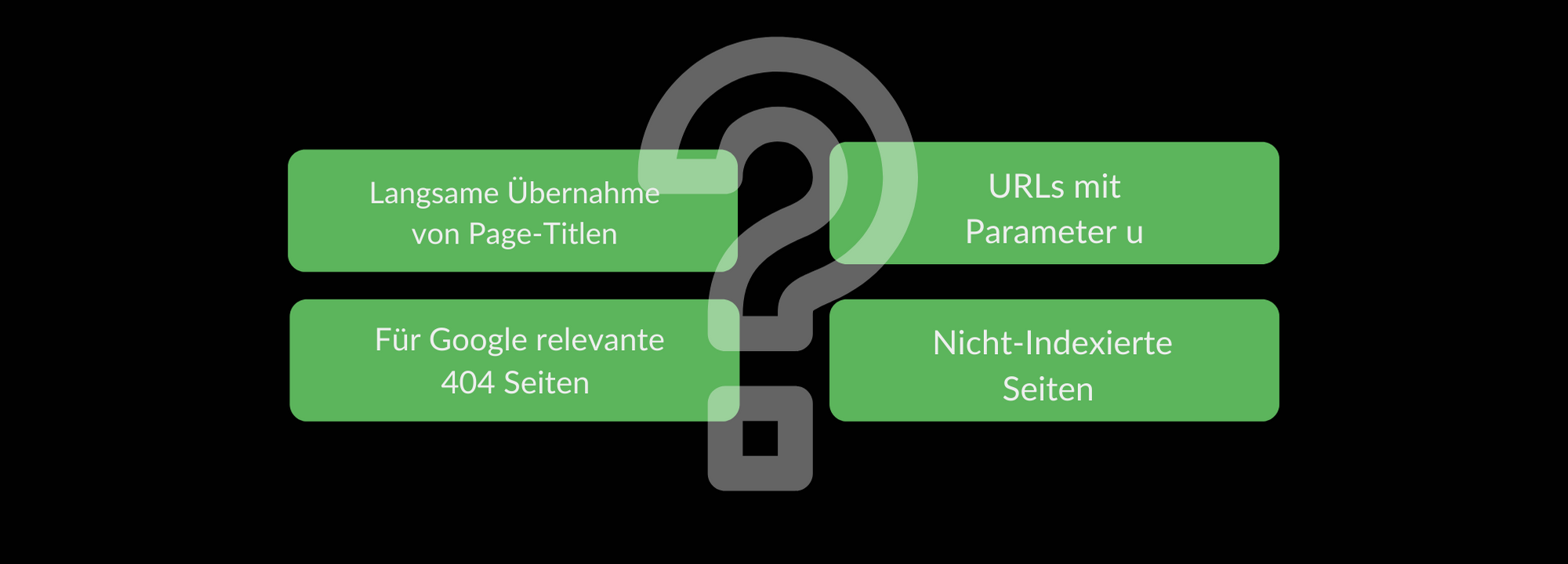

Es gibt viele gute Gründe für eine Logfile-Analyse. Die typischsten sind:

Bei diesen Problemen hilft dir die Logfile-Analyse. Damit findest du heraus, wie oft Unterseiten von Google aufgerufen werden. Und dadurch entdeckst du Fehler und kannst unnötig gecrawlte Unterseiten finden.

Bestandteile der Logfile Analyse

Wichtig: Grundsätzlich sind Logfile-Analysen für „kleine Seiten“ nicht sehr wichtig, weil Google diese in der Regel komplett crawlt. Außerdem hat Google weniger Probleme, wenn die Seite Serveranfragen schnell ausführen kann. John Mueller von Google hat sich 2019 via YouTube zum Thema Logfile-Analyse geäußert.

Ich empfehle, intensivere Logfile-Auswertungen erst bei einer Seitengröße ab 50.000 URLs durchzuführen – oder wenn die oben genannte Probleme auftauchen.

Was sind Logfiles?

Eine Logfile (dt. Logdatei) ist eine Datei, auf der alle Serverzugriffe protokolliert sind. Die Dateien werden jeden Tag erstellt und liegen auf deinem Webserver. Jeder Zugriff (Request) wird als ein Eintrag (Hit) mit der Serverzugriffszeit in einem Protokoll gespeichert.

Zusätzlich findest du für jeden Eintrag folgende Eigenschaften:

Wie sieht ein Logfile-Eintrag aus?

Die oben genannten Informationen findest du in folgendem Muster:

66.249.156.642 – – [17/Dec/2019:10:10:05 -0400] “GET /seo-trends-2019-zukunft/ h2” 200

“Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)”

Es gibt so viele Einträge in der Logfile, wie du Serveranfragen pro Tag hast. Selbst bei mittelgroßen Websites können die Zugriffe fünfstellige Werte an einem Tag übersteigen. Daher musst du die Daten bearbeiten.

Dazu gehören verschiedene Programme, auf die wir später eingehen. Außerdem ist es wichtig, die Einträge zu filtern und zu aggregieren, um die Daten richtig einschätzen zu können.

Wie filterst du die Anfragen des Googlebots heraus?

Die Logfile-Analyse kann nicht nur für die Suchmaschinenoptimierung genutzt werden. Die Logdateien zeigen dir die Zugriffe aller Besucher an. In diesem Beitrag steht die Optimierung für Google jedoch im Vordergrund.

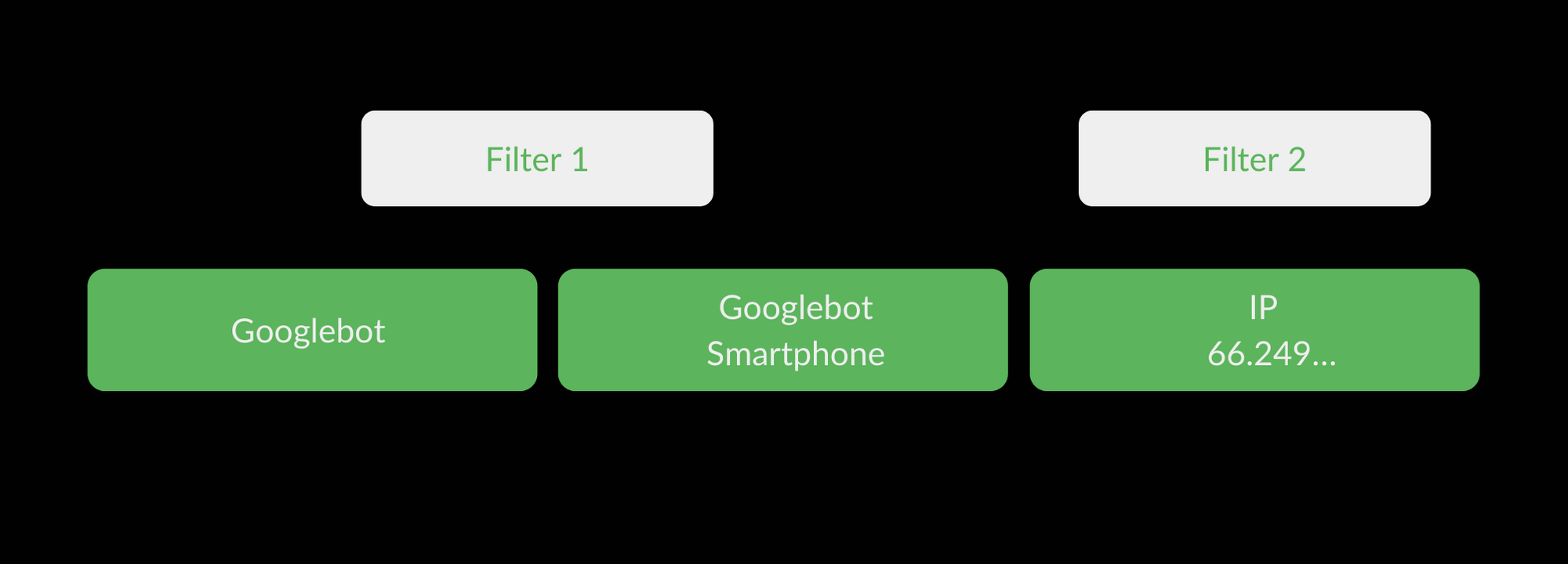

Die verschiedenen Googlebots hinterlassen im User Agent den Eintrag „Googlebot“ oder „Googlebot Smartphone“. Dies ist daher der erste Filter, den du setzen solltest. Allerdings kann jeder Benutzer mit einem Plug-in seinen User Agent mit dem Eintrag „Googlebot“ anreichern. Insofern reicht der Filter nicht aus, wenn du nur die Suchmaschine aus Mountain View analysieren willst.

Google crawlt (meist) mit einer gewissen IP. Diese fängt für gewöhnlich mit 66.249… an. Damit kannst du den Googlebot verifizieren und diese IP als zweiten Filter benutzen.

So filterst du Googlebots heraus

Wir wissen nun, was die einzelnen Logfile-Einträge sind und wie du die Requests des Googlebots herausfiltern kannst. Wie können die Einträge ausgewertet werden?

Welchen Umfang haben Logfiles?

Eine Webseite mit 30.000 Unterseiten kann alleine von Google bis zu 40.000 Requests pro Tag erhalten. Vorher müssen die Requests anderer Nutzer und fremder Bots herausgefiltert werden.

Die Zugriffszahlen für größere Zeiträume (z. B. ein Monat oder mehr) können schnell in die Millionen gehen. Aus diesem Grund kommt das beliebte Microsoft Excel schnell an seine Grenzen, weil Excel solche Datenmengen nicht effektiv bearbeiten kann.

Welche Tools helfen bei der Logfile-Auswertung?

Ich stelle dir nun ein paar Tools vor, die dir helfen, die Logfiles auszuwerten:

Microsoft Excel

Wie bereits erwähnt, stößt Excel bei der Auswertung der Logfiles irgendwann an seine Grenzen. Für kleinere Analysen (bis zu 100.000 Einträgen) reicht das Datenverarbeitungsprogramm allerdings aus.

Eine gute Anleitung, wie du Excel mit dem VBA-Modul für eine Analyse vorbereitest, findest du bei Builtvisible.

Screaming Frog Log File Analyser

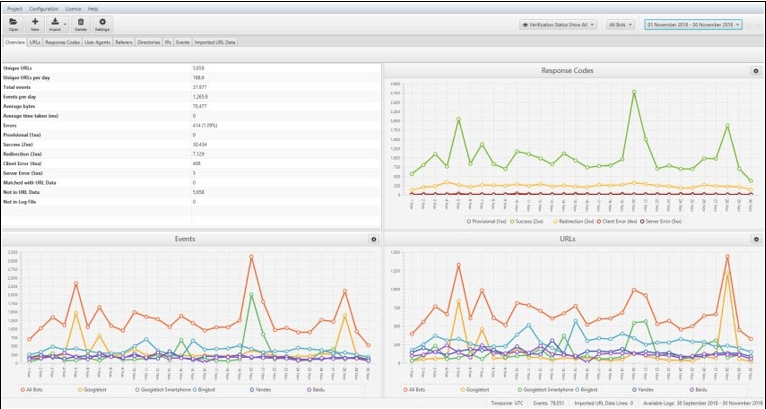

Vielleicht kennst du den Screaming Frog SEO Spider. Der englische SEO-Tool Anbieter bietet seit einigen Jahren den Log File Analyser an. Bei LEAP/ benutzen wir das Tool ebenfalls. Der Kostenpunkt liegt bei jährlich knapp 100 Euro und ist damit erschwinglich. Du kannst auch eine kostenlose Testversion herunterladen.

Was nimmt dir der Log File Analyser ab? Im Grunde ist er eine riesige Filtermaschine. Die Logfile-Dateien werden per Drag & Drop oder Upload eingespielt. Danach bereitet das Programm die Daten nach verschiedenen Kriterien auf: IP, User Agent (für dich wichtig: Googlebot), Status Code und Anzahl der Einträge pro Tag.

Du kannst die Daten mit einem normalen Screaming Frog SEO Spider Crawl verbinden. Der Nachteil ist, dass das Programm bei zu großen Datenmengen deinen Arbeitsspeicher stark beansprucht und gegebenenfalls nicht mehr reagiert.

Screaming Frog Log File Analyser Version 3.0

Tipp: Screaming Frog hat auf seiner Seite SEO-Guides, damit die Daten von verschiedenen Servervarianten (Apache, Amazon etc.) richtig verstanden werden können.

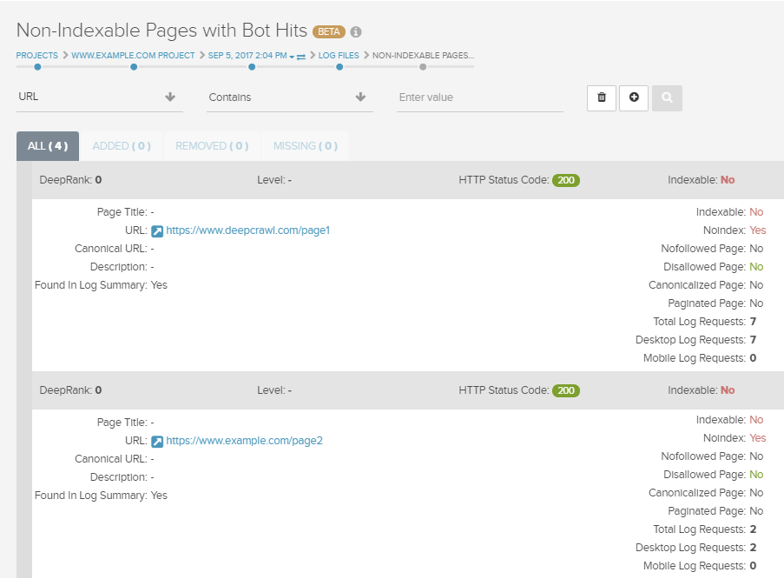

Deepcrawl

Seit 2017 bietet Deepcrawl eine Integration von Logfiles an. Das Tool Deepcrawl ist ein zusätzlicher Crwaler, der neben den Logfiles den Code und Inhalt deiner Seite bewertet. Du kannst somit sehr weitreichende Analysen durchführen. In dem userfreundlichen Interface siehst du auf einen Blick, wie oft indexierte Seiten von Google gecrawlt werden. Damit sparst du dir den Umweg, die Logfile-Analyse mit anderen Daten anzureichern.

Deepcrawl-Logfile-Auswertung

Ein weiterer Unterschied zu Screaming Frog ist, dass Deepcrawl kein Programm, sondern eine Website ist. Dadurch wird dein PC nicht so stark belastet.

Dieser Service hat natürlich seinen Preis, der sich auf die Größe der Website bezieht. Für bis zu 10.000 angeschauter URLs zahlt man 120 Euro pro Jahr. Bei großen Seiten steigt der Preis deutlich an.

Die bis hierhin vorgestellten Lösungen bieten die Vorteile, dass dir die Datenverarbeitung abgenommen wird und du auf einfache Softwarelösungen zurückgreifen kannst.

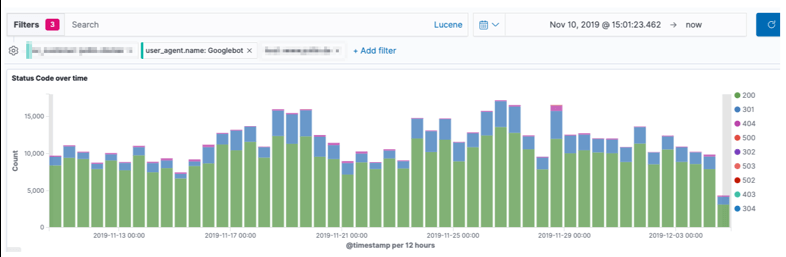

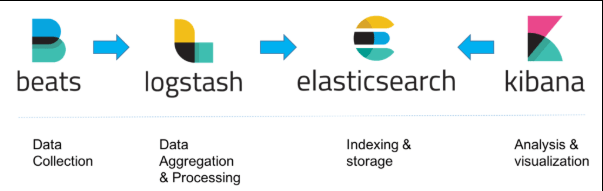

Elasticsearch, Logstash, Kibana (ELK)

Wenn du allerdings ein eigenes System aufbauen möchtest, gibt es die Option auf Kibana und das ELK-Stack zurückzugreifen:

Der Aufbau des ELK-Stacks

Mit Kibana & Co. habe ich bereits gute Erfahrungen gesammelt. Das Vorgehen bringt folgende Vorteile:

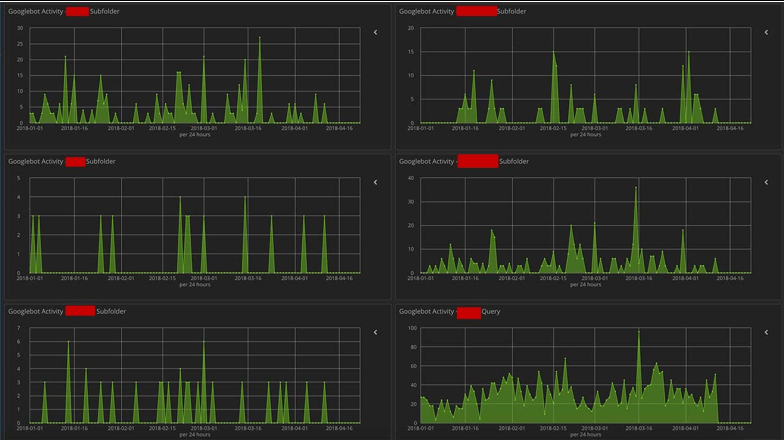

Kibana-Dashboard für die Zugriffe auf einzelne Verzeichnisse

Jetzt näher auf die Installation des ELK-Stack einzugehen, würde den Rahmen dieses Beitrags sprengen. Hier deshalb zwei Quellen für die Installation und Anregungen für Dashboards in Kibana.

Anwendungsfelder der Logfile-Analyse

Abschließend stelle ich dir noch drei Anwendungsfelder für die Logfile-Analyse vor.

Javascript & URL-Crawling

Bei modernen Websites werden oftmals verschiedene Elemente wie die Navigationsmenüs oder die Filterseiten mit unterschiedlichen Javascript-Anwendungen nachgeladen. Manchmal wird das von einem SEO-Manager bewusst gemacht, um die Links zu verstecken, manchmal wählt die IT-Abteilung aus anderen Gründen diesen Weg.

Nun ist aber die interne Verlinkung bei größeren Seiten für den SEO-Erfolg sehr wichtig. Deshalb solltest du unbedingt prüfen, ob Google deine Javascript-Konstruktion versteht. In den Logfile-Protokollen siehst du, ob diese Seiten von der Suchmaschine gecrawlt werden und wie oft.

404-Fehler

In der Google Search Console oder deinem normalen Crawling-Tool (z. B. Screaming Frog) werden 404-Seiten angezeigt. Obwohl Google sagt, dass 404-Seiten selbst kein Problem darstellen, wollen unerfahrene SEOs diesen Fehler oftmals unbedingt beheben.

Durch die Analyse kannst du einschätzen, wie oft Google die Seiten mit einem 404-Statuscode wirklich anschaut. Vielleicht sind die alten 404-Seiten aus Sicht von Google im Grunde gar nicht relevant. Dann brauchst du bis auf einen Check der externen Links keine weiteren Maßnahmen ergreifen.

Crawling-Häufigkeit

Mit der Analyse siehst du, in welchen Intervallen eine URL vom Googlebot aufgerufen wird. Zusätzlich kannst du prüfen, ob ähnliche URLs (kanonisierte URLs) ebenfalls gefunden werden.

Wenn sich Produkte häufig ändern oder viele neue (News)-Artikel erstellt werden, sollten diese möglichst regelmäßig gecrawlt werden. Sonst erkennt Google die Änderungen nicht. Wenn das nicht der Fall ist, musst du die folgenden Maßnahmen ergreifen, damit die wichtigen Seiten gefunden und öfter angeschaut werden:

Fazit: Logfiles für die Suchmaschinenoptimierung nutzen

Die Logfile-Analyse ist wichtig, wenn du verstehen willst, wie Google deine Website betrachtet. Sie hilft dir, wenn du für eine große Seite verantwortlich bist oder auf die eingangs geschilderten Probleme triffst.

Die im Beitrag vorgestellten Tools reichen aus, um belastbare Einschätzungen treffen zu können und auf dieser Basis dafür zu sorgen, dass Google vor allem die Seiten im Blick hat, die indexiert werden sollen.

Der Aufwand lohnt sich jedoch erst bei größeren Seiten. Also muss sich nicht jeder Blogger oder kleinere Shop mit weniger als 300 Produkten diese Mühe machen.