Experten-Webinar: SEO und KI

Jetzt anmelden

Dein Erfolg im E-Commerce hängt entscheidend davon ab, wie konsequent du deine Website optimierst. Jeder Klick, jeder Schritt im Checkout und jeder Kaufabschluss sind Ergebnisse von Entscheidungen, die Nutzer auf deiner Seite treffen. Wenn du diese Entscheidungen verstehen und systematisch verbessern willst, führt kein Weg an A/B-Tests vorbei. Sie sind das Instrument, das dir Klarheit verschafft und dir hilft, deine Conversion Rate nachhaltig zu steigern.

Bei LEAP setzen wir dafür auf einen klaren und strukturierten Prozess: den A/B-Testing-Cycle. Er besteht aus sechs Schritten, die sich immer wiederholen und dir helfen, valide Ergebnisse zu erzielen, Learnings zu generieren und deine Website Schritt für Schritt profitabler zu machen. Dieser Prozess ist nicht nur eine Methodik, sondern auch eine Denkweise: weg vom Bauchgefühl, hin zu datengetriebenen Entscheidungen. Ab 2025 kommt hinzu, dass KI-gestützte Tools die Effizienz von A/B-Tests noch einmal deutlich steigern werden, indem sie Muster im Nutzerverhalten automatisch erkennen, Hypothesen priorisieren und sogar Laufzeiten simulieren können.

A/B-Tests sind das Rückgrat einer erfolgreichen Conversion-Optimierung. Ohne sie riskierst du, Änderungen auf Basis von Annahmen oder Bauchgefühl umzusetzen – und das kann dich teuer zu stehen kommen. Jede Anpassung an deiner Seite, die nicht getestet wurde, kann zu Umsatzverlusten führen, weil sie die Nutzer vielleicht verwirrt oder den Conversion-Funnel unbewusst schwächt.

Mit A/B-Tests stellst du sicher, dass Änderungen valide geprüft werden. Du gewinnst Erkenntnisse darüber, wie deine Zielgruppe tickt, was sie motiviert, welche Elemente Vertrauen schaffen und welche Hürden beseitigt werden müssen. Selbst wenn ein Test nicht den gewünschten Uplift bringt, ist er wertvoll, weil er dir zeigt, welche Richtung nicht funktioniert und welche Hypothesen du künftig verfeinern solltest.

Die Auswirkungen gehen über die reine Conversion Rate hinaus. Jeder Test, den du durchführst, zahlt auf Umsatz, Profitabilität und Brand Trust ein. Denn je klarer und nutzerfreundlicher deine Seite ist, desto eher vertrauen Kunden deinem Shop und kaufen wieder. Auch deine Marketingkampagnen profitieren, weil du Daten und Insights aus den Tests für bessere Botschaften und Landingpages nutzen kannst.

Der Einfluss von KI verstärkt diesen Effekt. Sie erkennt Muster, die du manuell kaum sehen würdest, und liefert dir Vorschläge, wo Optimierungspotenziale stecken. So wird A/B-Testing vom reinen Optimierungswerkzeug zum strategischen Steuerungsinstrument für Wachstum.

Damit A/B-Testing funktioniert, brauchst du einen klaren Rahmen. Planloses Testen ist nicht nur ineffizient, sondern auch gefährlich, weil es dich von den eigentlichen Hebeln ablenken kann. Deshalb nutzen wir bei LEAP einen sechsstufigen Prozess, der sich nach jedem Durchlauf wiederholt. Er besteht aus folgenden Schritten:

Jeder dieser Schritte ist wichtig, und erst das Zusammenspiel macht den Erfolg aus. Nach Abschluss beginnt der Cycle wieder von vorne – dynamisch, iterativ und datengetrieben.

Analyse: Wo lohnt sich ein Test?

Am Anfang steht die Analyse. Hier entscheidest du, wo du testen solltest, um den größten Hebel zu erreichen.

Zunächst schaust du auf die quantitativen Daten. Welche Seiten haben viel Traffic, aber eine schlechte Conversion Rate? Wo ist die Bounce Rate besonders hoch? Welche Schritte im Checkout führen häufig zum Abbruch? Solche Fragen beantwortest du mit Tools wie Google Analytics oder Mouseflow. Besonders wichtig ist es, deine Daten zu segmentieren – nach Gerätetyp, nach Trafficquelle oder nach Nutzerstatus. Oft zeigt sich, dass Probleme nicht allgemein gelten, sondern bestimmte Segmente besonders stark betreffen.

Daneben gibt es die qualitative Analyse. Hier betrachtest du deine Seiten mit einem kritischen Blick. Sind sie klar strukturiert? Finden Nutzer die Informationen, die sie suchen? Gibt es Elemente, die verwirren oder Vertrauen zerstören? Methoden wie Heuristiken, Best Practices oder Wettbewerbsanalysen helfen dir dabei, Schwachstellen zu erkennen. Auch Usability-Tests oder Umfragen können wertvolle Hinweise liefern, auch wenn sie zeitaufwendiger sind.

Aus beiden Perspektiven entsteht ein Bild, das dir zeigt, wo die größten Potenziale liegen. Um die Arbeit planbar zu machen, empfehlen wir, eine Testing Roadmap zu erstellen. Bei LEAP nutzen wir ein Backlog an Testideen, aus dem wir die nächsten Schritte priorisieren. Dabei helfen Kriterien wie:

Hypothese: Vom Insight zur Testidee

Die Analyse liefert dir Probleme und Beobachtungen, aber noch keine Testidee. Der nächste Schritt ist die Hypothese. Eine Hypothese übersetzt die Erkenntnisse in eine konkrete Annahme, die du überprüfen kannst.

Das Schema ist einfach: Wenn du etwas auf der Seite änderst, dann sollte sich ein bestimmtes Ziel verbessern, weil eine bestimmte Heuristik oder Beobachtung dafür spricht. Ein Beispiel: Wenn du den Call-to-Action-Button größer und auffälliger gestaltest, dann steigt die Klickrate, weil Nutzer Entscheidungen schneller treffen, wenn der nächste Schritt klar sichtbar ist.

Die Formulierung einer guten Hypothese zwingt dich, präzise zu sein. Du legst fest, was genau geändert wird, welches Ziel betroffen ist und warum du glaubst, dass es funktioniert. Wichtig ist, dein Design- und Entwicklungsteam früh einzubinden. Sie können dir Hinweise geben, ob die Idee technisch machbar ist, und oft entstehen dabei weitere wertvolle Vorschläge.KI kann auch hier unterstützen. Algorithmen sind in der Lage, historische Daten zu analysieren und die Wahrscheinlichkeit zu berechnen, dass eine Hypothese erfolgreich ist. So investierst du deine Ressourcen gezielter.

Variation: Die Hypothese sichtbar machen

Die Hypothese wird nun in konkrete Varianten übersetzt. Je nach Traffic kannst du mehrere Varianten gleichzeitig testen, um die Chancen auf ein positives Ergebnis zu erhöhen.

Wichtig ist, dass du vorab die Laufzeit des Tests berechnest. Dafür brauchst du die aktuelle Conversion Rate, die tägliche Nutzeranzahl, die erwartete Verbesserung und das gewünschte Signifikanzniveau. Meist wird mit 95 Prozent gearbeitet.

Hier spielen auch die klassischen Fehlerarten eine Rolle:

Beide Fehler sind kostspielig, und deshalb ist sauberes Testdesign so entscheidend.KI-Tools können dir helfen, Varianten effizient zu erstellen – sei es durch generierte Texte, neue Layoutvorschläge oder optimierte Bilder. Wichtig bleibt aber, dass jede Variante klar testbar ist und die Ergebnisse valide bleiben.

Setup: Präzision ist Pflicht

Zuerst wird der Test technisch umgesetzt und ins Development gegeben. Danach legst du die Ziele fest. Neben einem Primärziel, etwa dem Kaufabschluss, solltest du immer auch Sekundärziele einplanen. Dazu gehören Schritte im Checkout-Funnel wie:

Zuerst wird der Test technisch umgesetzt und ins Development gegeben. Danach legst du die Ziele fest. Neben einem Primärziel, etwa dem Kaufabschluss, solltest du immer auch Sekundärziele einplanen. Dazu gehören Schritte im Checkout-Funnel wie:

Vor allem im Checkout solltest du möglichst alle relevanten Interaktionen ins Targeting aufnehmen. Nur so kannst du am Ende nachvollziehen, wie Nutzer mit deiner Variante interagieren und welche Effekte sie wirklich hat.

Bevor der Test live geht, musst du eine gründliche Qualitätssicherung durchführen. Prüfe jede Variante auf verschiedenen Geräten und Browsern, um Fehler auszuschließen. Schon kleine technische Probleme können Ergebnisse verfälschen oder sogar Umsatz kosten.

Auch hier bieten KI-gestützte Tools einen Vorteil, weil sie automatisch Klickpfade erkennen und dir helfen, wichtige Mikrointeraktionen zu tracken, die du sonst vielleicht übersehen würdest.

Setup: Präzision ist PflichtTestdurchführung: Monitoring und Anpassung

Wenn der Test live ist, beginnt die Phase der Durchführung. Viele glauben, dass man den Test einfach laufen lassen kann, aber das ist ein Fehler.

Du musst den Test täglich beobachten. Läuft alles technisch korrekt? Gibt es Auffälligkeiten? Entwickelt sich eine Variante so negativ, dass sie vorzeitig gestoppt werden sollte? Diese Fragen musst du beantworten.

Auch hier gilt: A/B-Testing ist ein iterativer Prozess. Oft liefert ein Test nicht die endgültige Antwort, sondern die Grundlage für weitere Follow-up-Tests. Flexibilität ist daher wichtig.KI-Systeme können dich entlasten, indem sie automatisch Anomalien erkennen und dich warnen, wenn sich etwas außerhalb der erwarteten Parameter entwickelt. So reagierst du schneller und vermeidest Fehler.

Auswertung & Implementierung: Von Daten zu Umsatz

Die letzte Phase ist die Auswertung. Hier entscheidest du, was mit den Ergebnissen passiert.

Grundsätzlich gibt es drei mögliche Outcomes. Erstens: Die Variante performt besser und das Ergebnis ist signifikant. In diesem Fall solltest du die Änderung implementieren und die Learnings dokumentieren. Zweitens: Die Variante performt schlechter, ebenfalls signifikant. Dann verwerfst du die Hypothese, hast aber trotzdem Erkenntnisse gewonnen. Drittens: Der Test wird auch nach langer Laufzeit nicht signifikant. Das passiert häufiger, als man denkt, und auch das liefert dir Hinweise für deine Roadmap.

Wichtig ist, dass du die Ergebnisse segmentierst. Eine Variante kann insgesamt neutral wirken, aber in einzelnen Segmenten sehr stark. Vielleicht funktioniert sie bei Desktop-Nutzern, aber nicht auf Mobile. Oder sie steigert Conversion in Chrome, während sie in Safari bremst. Solche Erkenntnisse sind Gold wert, weil sie dir helfen, personalisierte Ausspielungen zu entwickeln.KI unterstützt dich dabei, solche Muster automatisch zu erkennen. Sie kann Subgruppen identifizieren, die unterschiedlich reagieren, und dir Empfehlungen geben, wie du die Learnings umsetzt.

Statistik im A/B-Testing: Grundlagen für valide Ergebnisse

Damit A/B-Testing dir wirklich valide Antworten liefert, musst du die Statistik verstehen.

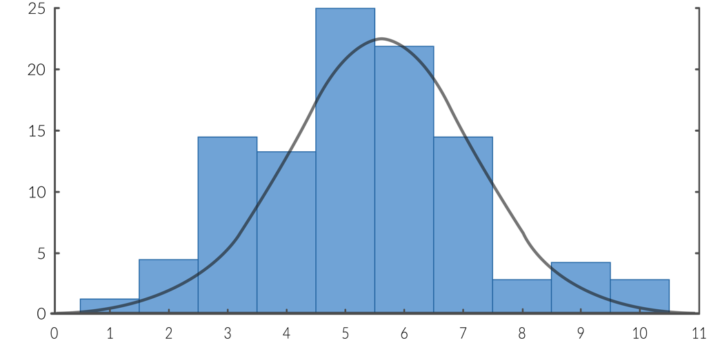

Die Normalverteilung, auch Gaußsche Glockenkurve genannt, zeigt, wie sich Daten bei ausreichend großer Stichprobe verteilen. Je größer die Stichprobe, desto stabiler und verlässlicher sind die Ergebnisse.

So kann eine Gaußsche Glockenkurve bzw. Normalverteilung aussehen

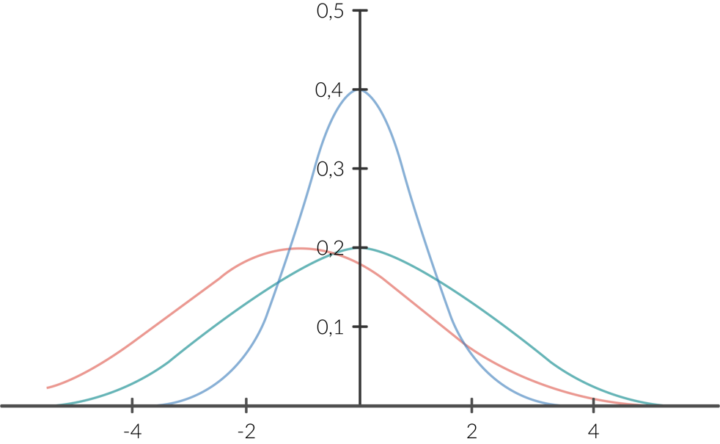

Wenn wir mehrere Varianten haben (z. B. Vollmilch, Zartbitter und Haselnuss), werden entsprechend viele Kurven gebildet.

Die Kurven im Vergleich

Die blaue Kurve hat die geringste Standardabweichung, d. h. die Daten streuen weniger stark um den Mittelwert.

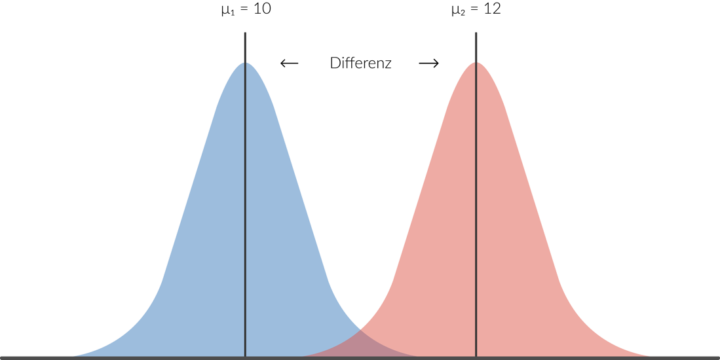

Bei einem t-Test werden die Mittelwerte miteinander verglichen, um einen Mittelwertunterschied herauszufinden. Dieser Unterschied muss hinsichtlich seiner Signifikanz überprüft werden. Die Signifikanz ist die Wahrscheinlichkeit, dass ein gefundener Unterschied nicht auf rein zufällige Schwankungen zurückzuführen ist und wird mit dem Chi-Quadrat-Test berechnet.

Die KuDie Differenz

Es gibt drei typische Gründe, warum ein Test nicht signifikant wird:

Alle drei Faktoren kannst du beeinflussen – durch stärker kontrastierende Varianten, durch längere Laufzeiten oder durch die Konzentration auf Seiten mit ausreichend Besuchern.

Auch hier macht KI den Prozess effizienter. Sie kann dir Prognosen über notwendige Stichprobengrößen geben und Anomalien in den Daten schneller erkennen. Am Ende bleibt aber die Verantwortung bei dir: Nur wenn du die Ergebnisse richtig interpretierst, triffst du die richtigen Entscheidungen.

Viele Betreiber fragen sich, ob es normal ist, dass nicht jeder Test erfolgreich ist. Die Antwort lautet: ja. Je optimierter eine Seite bereits ist, desto weniger „Low Hanging Fruits“ gibt es. Das bedeutet, dass viele Tests neutral ausfallen oder keinen klaren Uplift bringen. Das ist kein Misserfolg, sondern Teil des Prozesses. Jeder Test liefert dir Erkenntnisse, die du nutzen kannst.

Eine weitere häufige Frage betrifft parallele Tests:

Warum sollte man nicht mehrere Tests gleichzeitig laufen lassen? Ganz einfach: weil sich Effekte überschneiden können. Wenn ein Nutzer auf der Produktseite getestet wird und dann im Checkout erneut, weißt du nicht, welcher Test sein Verhalten beeinflusst hat. Ausnahme: Wenn du Nutzergruppen strikt trennst, zum Beispiel nach Gerätetyp, ist es möglich.

Auch die Laufzeit ist ein Thema.

Wie lange sollte ein Test laufen? Die Antwort hängt von Traffic, erwarteter Verbesserung und Konfidenzniveau ab. Grundsätzlich gilt: lieber etwas länger laufen lassen, um valide Daten zu sammeln. Abkürzungen führen schnell zu falschen Entscheidungen.

A/B-Testing ist weit mehr als ein Werkzeug für Conversion-Optimierer. Es ist ein strategischer Hebel, mit dem du Wachstum steuerst, Risiken reduzierst und deine Kunden besser verstehst. Der LEAP-Testing-Cycle gibt dir einen Rahmen, in dem du strukturiert und effizient arbeiten kannst.

Für Entscheider bedeutet das: Jeder Test bringt dir Erkenntnisse, die Umsatz, Profitabilität und Markenvertrauen stärken. Mit KI wird der Prozess schneller und präziser, weil sie dir hilft, Muster zu erkennen und Entscheidungen zu priorisieren. Und auch wenn nicht jeder Test ein klarer Gewinner ist, liefert er dir Hinweise, die deine Roadmap schärfen und deine digitale Strategie voranbringen.

Takeaway: Wenn du A/B-Testing konsequent und strukturiert einsetzt, wird es vom operativen Tool zum strategischen Steuerungsinstrument für profitables Wachstum.